С селфхармом и суцидом борются только Pinterest и TikTok

Photo by Annie Spratt on Unsplash

Как проводилось исследование

После вступления в силу в ЕС Закона о цифровых услугах (DSA) 26 сентября 2023 года крупнейшие онлайн-платформы стали обязаны публиковать информацию о всех решениях по модерации контента. Molly Rose Foundation проанализировал более 12 млн таких решений, принятых с сентября 2023 года по апрель 2024 года шестью ведущими технологическими платформами: Instagram, Facebook, TikTok, Pinterest, Snapchat и X. Из этого числа были выделены решения, в которых причиной для модерации в связи с нарушениями правил пользования платформой называлось «самоповреждение». В Законе о цифровых услугах этот термин толкуется в расширительном смысле — суицид, нанесение себе травм, нарушения пищевого поведения и другие способы причинения вреда своему телу.

Как соцсети модерируют контент на тему самоповреждения

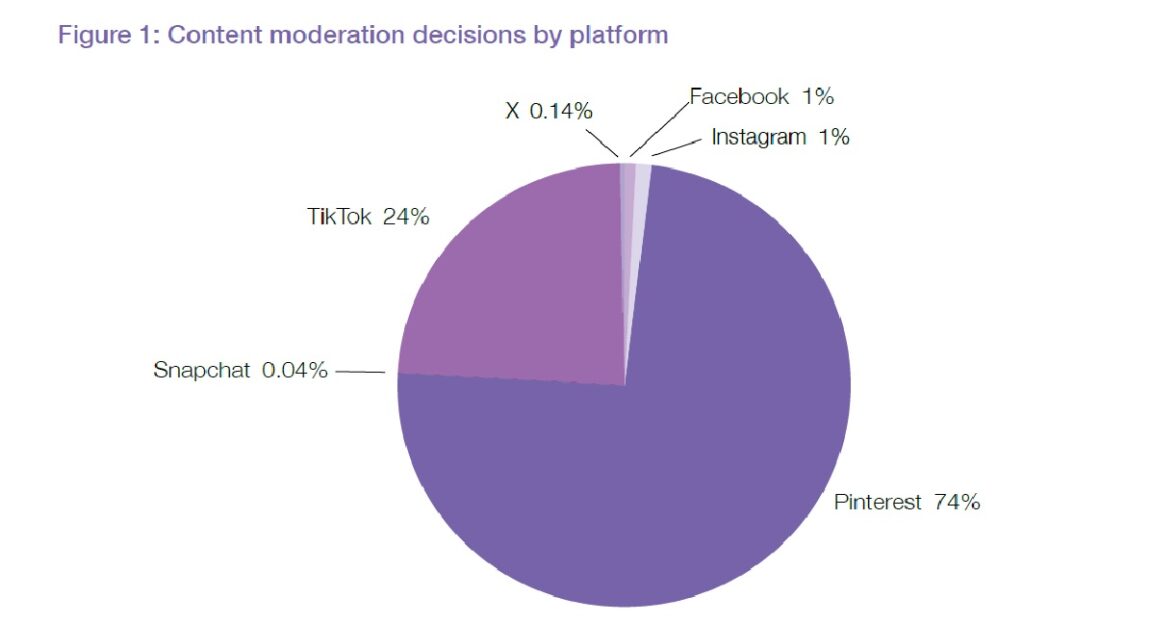

Анализ сведений, сообщенных соцсетями, показал, что активнее всего борется с вредным для подростков контентом Pinterest — около 74% постов на тему самоповреждений были замечены на этой платформе. Примерно каждый четвертый случай (24%) модерации приходится на долю TikTok. Доли двух соцсетей компании Meta** — Facebook и Instagram — 1,28% и 0,96% соответственно. Что касается Х, то его доля составила 0,14% подобных решений. У Snapchat еще меньше — 0,04%.

«Самоповреждение» — не самая частая причина нарушений. Из 12 194 588 случаев, отмеченных на всех шести платформах за указанный период времени, больше всего (33%) было связано с нелегальным контентом, 23% с нелегальными или небезопасными продуктами, 18% с порнографическим или сексуализированным контентом. Что касается постов, посвященных самоповреждениям, то они составляли 2% от общего количества нарушений.

Авторы доклада указывают на низкую активность Meta в борьбе с подобным контентом, несмотря на то, что компания обладает большими возможностями для обнаружения вредоносной информации. Это доказывает, например, следующий факт: 90% сообщений о сексуальном насилии в отношении детей, получаемых Национальным центром по делам пропавших без вести и эксплуатируемых детей США, поступает от Meta.

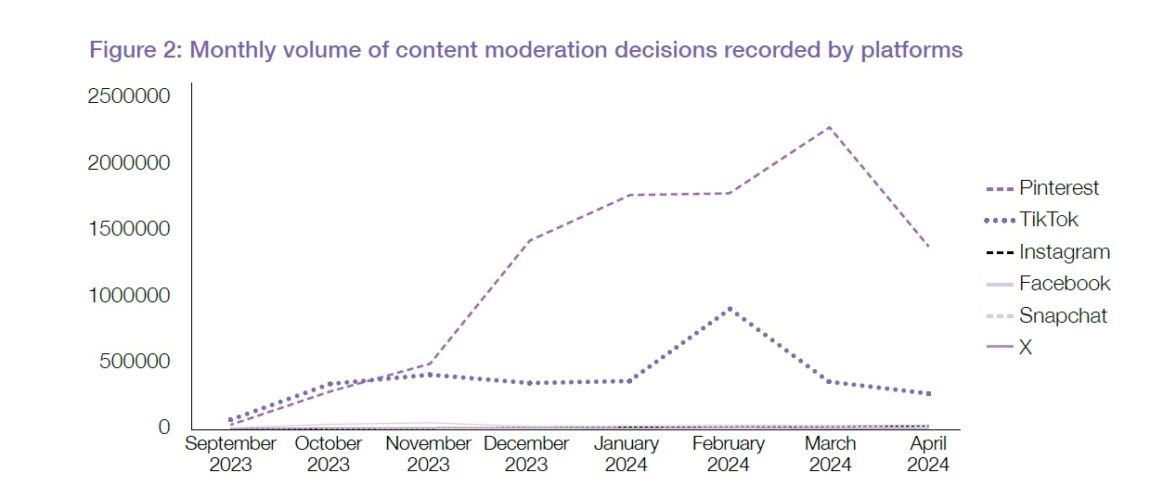

Если посмотреть на график модерации контента о самоповреждении по месяцам, то видно, что Pinterest и TikTok cо временем стали действовать активнее, чего нельзя сказать о других онлайн-платформах.

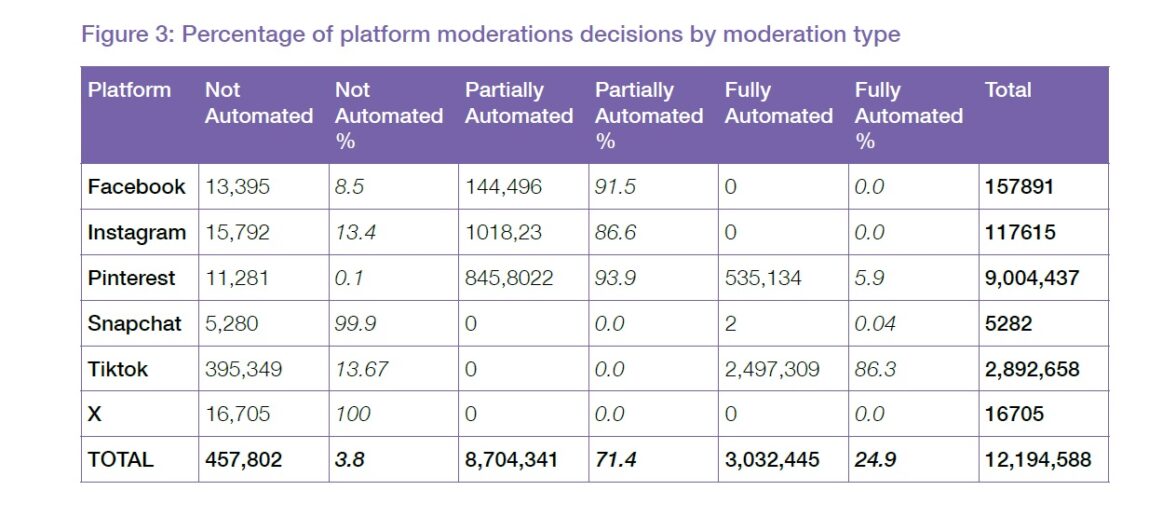

Решения о модерации контента о самоповреждении могут приниматься несколькими способами — вручную, автоматически и полуавтоматически (модератор-человек замечает вредоносный контент, после чего автоматически запускается поиск копий данного поста или аналогичных постов). На разных платформах применяется разный подход. В соцсетях Meta подавляющее большинство решений принимается полуавтоматически (остальные — вручную). В сети Pinterest используются все варианты, но преобладает полуавтоматический (93,9% случаев). В Snapchat в 99,9% случаев борьба с контентом о самоповреждении велась вручную. В TikTok в 86,3% случаев использовался автоматический способ борьбы. В Х модерация контента о самоповреждении велась только вручную.

У авторов доклада есть ряд вопросов к компаниям, которым принадлежат соцсети. Почему, например, технологические компании не всегда используют именно технологические возможности для борьбы с таким контентом, полагаясь на сотрудников-модераторов и не используя автоматический контроль за публикациями? Почему в соцсетях Meta обнаруживается так мало запрещенного контента по сравнению с TikTok и Pinterest несмотря на схожий подход к борьбе с ним?

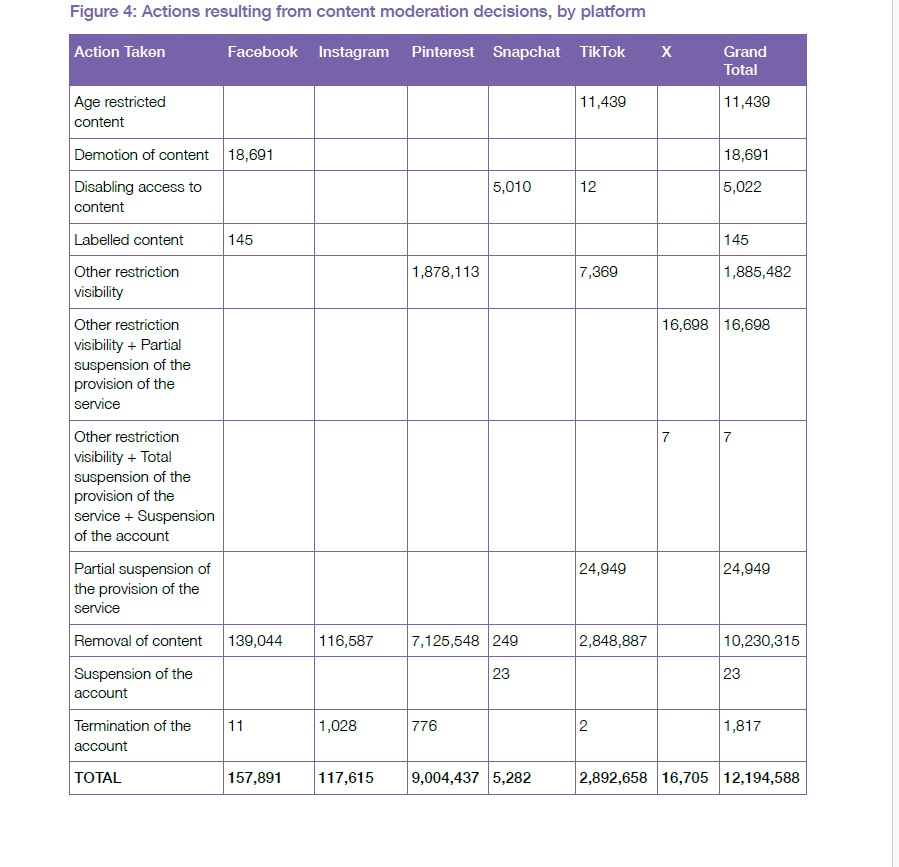

В 84% случаях контент, отмеченный как нарушающий правила сообщества в связи с темой самоповреждения, удалялся из соцсетей. Удалено было в общей сложности 10 230 315 подобных публикаций. Такой способ использовался на всех платформах, кроме Х. На Х всегда использовался следующий подход — ограничение видимости публикации и частичная приостановка аккаунта. Только частичная приостановка аккаунта использовалась в Snapchat. В Pinterest довольно активно использовалось ограничение видимости подобных публикаций. В Facebook использовались два метода, не использовавшиеся в других соцсетях — публикация могла быть снижена в выдаче, к ней могло быть добавлено предупреждение. В TikTok принимались разные меры — ограничение доступа во возрасту, ограничение видимости, приостановка доступа к контенту, частичная приостановка аккаунта.

Высшая, или, скорее, исключительная мера наказания — закрытие аккаунта — использовалась редко, а в Snapchat и X — никогда. Всего за охваченный докладом период времени было закрыто 1817 аккаунтов, из них 1028 в Instagram, 776 в Pinterest, 11 в Facebook и 2 в TikTok.

Оперативность принимаемых мер различается у разных платформ. Так, в Х всегда реагировали в день публикации, в Snapchat подобная оперативная реакция была зафиксирована в 97% случаев, в TikTok — в 94,4% случаев, в Instagram — в 87% случаев. Показатель Facebook — 67%. При этом 16% решений выносились в отношении публикаций, размещенных в Facebook более, чем 100 днями ранее, а в одном случае соцсеть разобралась с вредной публикацией, датированной 2009 годом. Самым медлительным оказался Pinterest. Решения принимались в день предполагаемого нарушения лишь в 19% случаев.

Molly Rose Foundation

Благотворительный фонд Molly Rose Foundation был основан в 2018 году в Лондоне Иеном Расселом и Джанет Рассел. Годом раньше их 14-летняя дочь Молли покончила с собой. В свидетельстве о смерти причиной смерти было названо «нанесение себе вреда в состоянии депрессии и под негативным воздействием онлайн-контента».

* продукт компании Meta (признана экстремистской организацией и запрещена в РФ)

** признана экстремистской организацией и запрещена в РФ

Лучшее в блогах

Вам понравится

Более 95% женщин считает привлекательным, если мужчина на досуге читает, изучает иностранные языки, играет на музыкальных инструментах или увлекается кулинарией. Но только трети женщин нравится, если мужчина коллекционирует комиксы, занимается косплеем и тратит время на дебаты с теми, кто придерживается другой точки зрения. Увлечение маносферой, азартными играми и порнографией не одобряет большинство. Эти и другие выводы содержатся в исследовании, результаты которого на сайте Date Psychology.

Составить завещание никогда не рано. Личное имущество, например, недвижимость, автомобиль, драгоценности и другие материальные ценности переходят к наследникам. Это традиция. А как насчет цифровых активов? Пароли, логины, криптокошельки, инвестиционные портфели, коды доступа к мобильному банкингу и даже учетные данные социальных сетей также нуждаются в ком-то, кому перейдут после смерти их владельца. Сколько людей на самом деле имеют загробные планы относительно своих цифровых активов, выяснил портал All About Cookies, который опросил 1000 американцев о том, как они планируют распределить свое цифровое наследство.