Проверяем индексацию сайта поисковыми системами

Предыдущую часть гайда можно найти здесь.

Я постаралась включить в инструкцию только то, что администратор сайта может исправить своими силами без помощи разработчика. Мы в студии НАДО сейчас активно занимаемся проектами в сфере туризма и спорта, поэтому в качестве примера я выбрала магазин экипировки для активного отдыха ЭкипЛэнд.

Что такое индексация

Как сайт вообще попадает в список результатов поисковиков? Поисковые боты Google, Яндекса и других систем сканируют все сайты, размещённые в сети, оценивают их и выбирают самые качественных по наполнению и подходящие под запросы пользователей. Самые лучшие вы видите на первой странице выдачи, когда спрашиваете что-то у Google или Яндекса, плохие — не видите вообще, потому что они лежат на последних страницах.

Но эти параметры будут не важны, если роботы не обнаружат ваш сайт в интернете. Для этого нам надо проверить работу файлов sitemap.xml и robots.txt. С этим помогут Яндекс Вебмастер и Google Search Console.

Проверка Robots.txt

Файл robots.txt — это список инструкций для поисковых роботов. Они говорят поисковым роботам, какие URL-адреса на вашем сайте им разрешено обрабатывать.

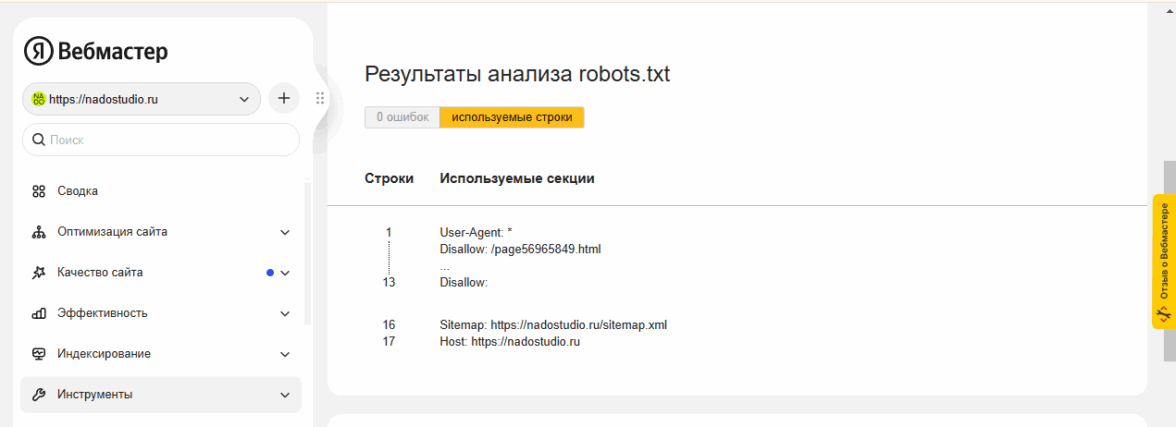

Оценить корректность заполнения файла robots поможет Яндекс Вебмастер. Во вкладке «Инструменты» → «Анализ robots.txt» можно увидеть, не содержит ли файл ошибки и какие строки в нём учитывает поисковый робот.

Проверка Sitemap.xml

Файл sitemap.xml называют картой сайта — она помогает поисковым роботам ориентироваться среди папок и документов вашего ресурса. Мы можем объяснить роботам порядок сканирования страниц и указать, что контент на странице обновился и её надо проиндексировать ещё раз, поменяв дату публикации.

Проверить sitemap на ошибки можно в разделе Вебмастера «Инструменты» → «Анализ файлов Sitemap». Откройте главную страницу вашего сайта, добавьте к нему в адресной строке /sitemap.xml и скопируйте адрес. Вставьте его в поле Яндекс Вебмастера и нажмите «Проверить».

Как проверить, все ли страницы сайта проиндексированы

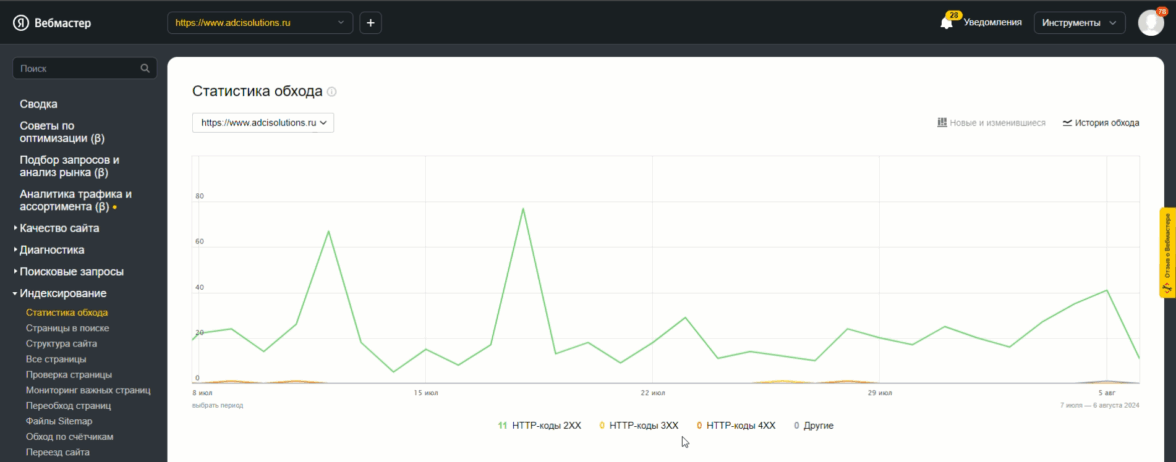

В Яндекс Вебмастере заходим в раздел «Индексирование» — потом в «Статистику обхода».

Код, начинающийся с цифры 4, говорит о том, что робот не смог достучаться до страницы и с ней что-то не так, её нужно починить. Если страница работала (то есть имела статус 200 ОК), а потом перестала, вы увидите это в логе под графиком. Код, начинающийся с цифры 3 — это не страшно, он говорит о том, что на странице настроена переадресация.

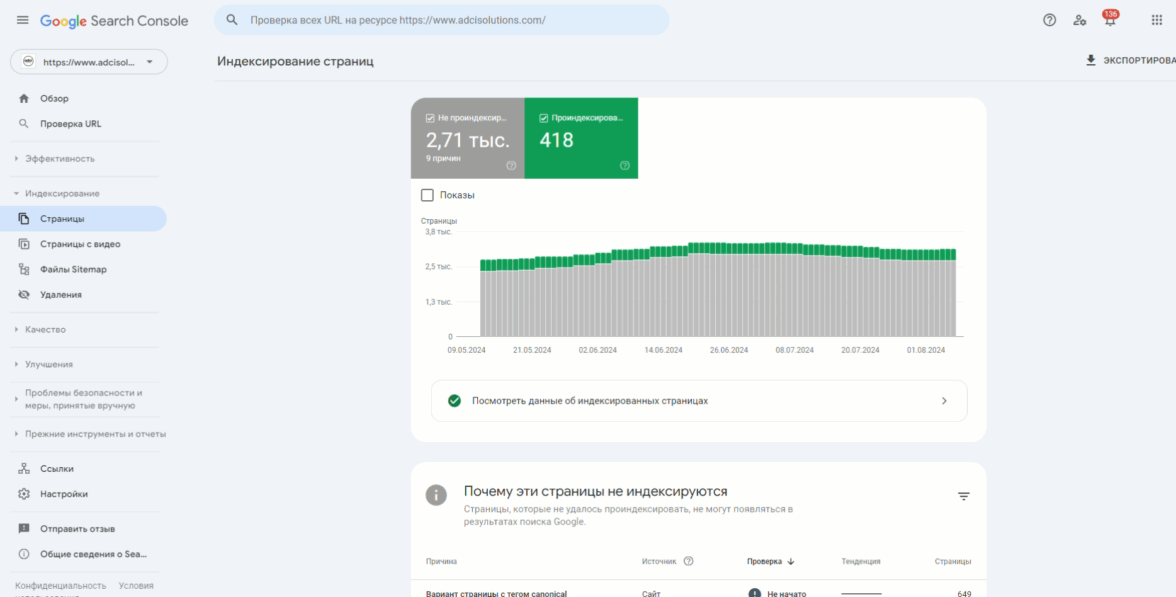

В Google Search Console мы ищем вкладку «Индексирование». Здесь можно увидеть отчёт о проиндексированных страницах.

Не обязательно все страницы сайта должны попасть в поисковые системы. Редиректы, закрытые служебные страницы, странички, которые обнаружены роботами, но ещё не оценённые ими — все они попадут в категорию непроиндексированных. Гугл предоставляет список причин непокрытия страниц и перечень таких страниц, поэтому можно самостоятельно определить, должна ли эта страница вообще попасть в выдачу или она специально скрыта.

Зайдите также в отчёты «Проблемы безопасности» и «Меры, принятые вручную», чтобы проверить сайт на бан от Google.

Как индексировать страницу

Нельзя повлиять непосредственно на скорость анализа и сканирования сайта, но вы можете привлечь внимание поисковых систем к непроиндексированным страницам.

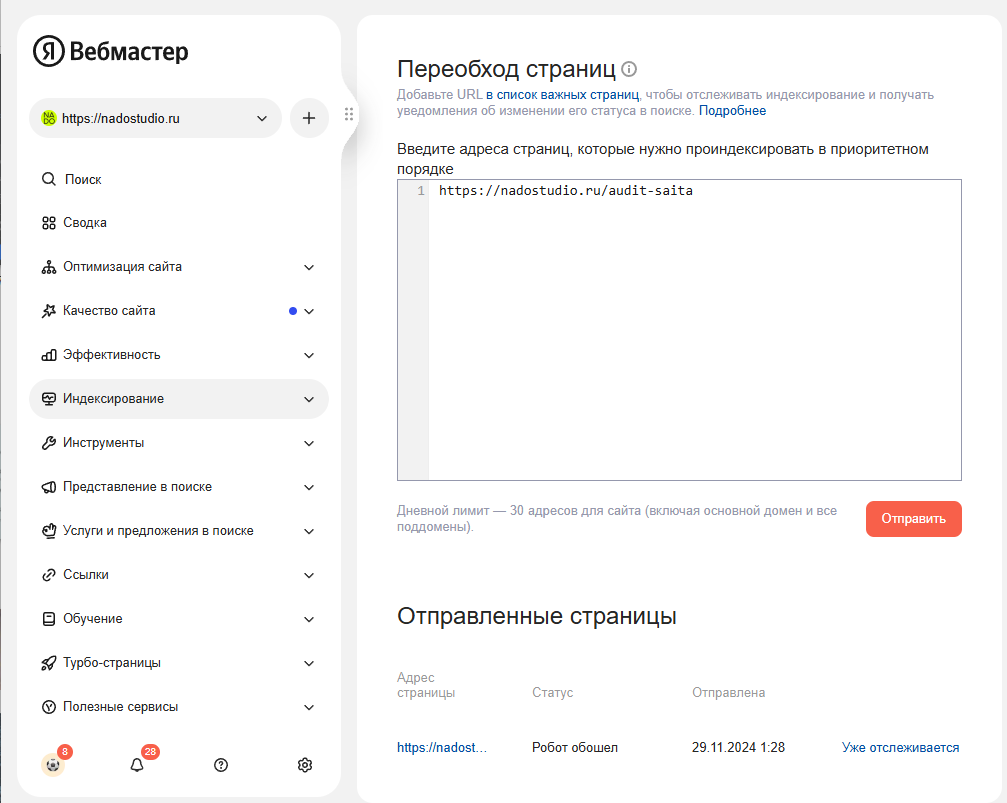

В Яндексе Вебмастере заходим в «Индексирование» → «Переобход страниц», вставляем URL нужных страниц и жмём «Отправить».

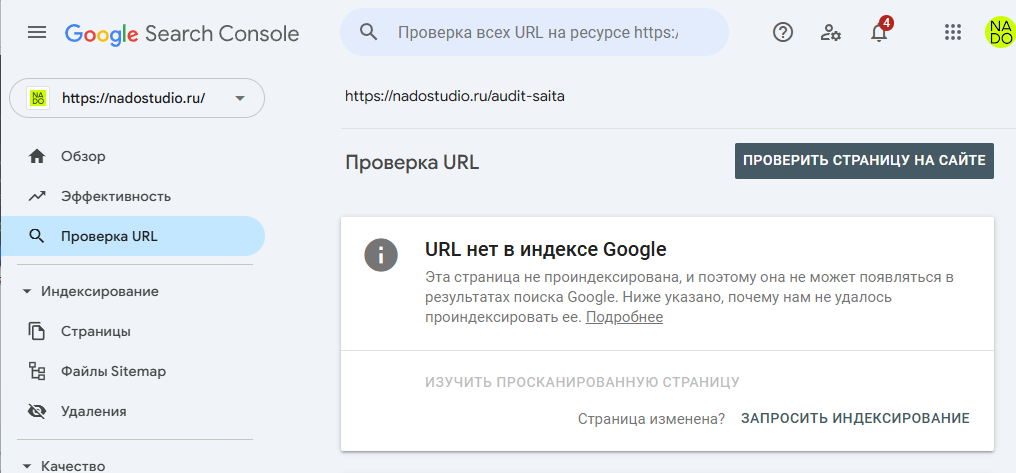

В Google Search Console кликаем на «Проверку URL», вставляем адрес и запрашиваем индексирование.

Что делать, если страница не индексируется

Если страница всё еще не попадает в выдачи поисковиков, нам надо убедиться, что она соответствует некоторым правилам. Вот список причин, почему поисковые системы могут игнорировать ваш сайт:

-

прошло мало времени с момента создания страницы: поиск и индексация занимает у большинства поисковиков от четырёх дней до четырёх недель;

-

в настройках страницы стоит галочка рядом с тегом noindex. Тег noindex в HTML-коде — это сигнал для краулеров игнорировать страницу;

-

на странице не настроены метатеги и микроразметка;

-

на странице мало полезного контента — без этого поисковые системы не будут добавлять её в выдачи;

-

в вашем URL-адресе слишком много слэшей (косых чёрточек), что означает большую вложенность, то есть количество разных разделов и подразделов на сайте. Чем их больше, тем более глубоко находится новая страница, и роботы должны сделать несколько прыжков со страницы на страницу, чтобы до неё докопаться;

-

ваш сайт медленный или размещён на нестабильном сервере. В результате роботы поисковых систем просто не получат ответы на свои запросы и пропустят сайт.

Теперь когда мы убедились, что поисковые системы видят страницы нашего сайта, можно переходить к аудиту дизайна и удобства сайта для пользователя. Если у вас остались вопросы, задавайте их в нашем телеграм-канале.

Лучшее в блогах

Вам понравится

Хотите узнать, как безопасно купить голоса в опросах ВК через iPhone? Рассказываем о надёжных сервисах, удобных мобильных интерфейсах и нюансах оплаты. Разбираем цены, гарантии и реальные отзывы. Узнайте, где найти качественный трафик, попробовать тестовые пакеты и избежать рисков.

Сколько подписчиков ВК надо для заработка — вопрос, который интересует администраторов сообществ на разных этапах развития. Количество участников напрямую влияет на доход от рекламы, партнерских программ и продвижения собственных проектов. В этой статье мы разберём, какое минимальное число подписчиков обеспечивает стабильный заработок, какие методы привлечения аудитории работают лучше всего и как совмещать органический рост с платными инструментами продвижения.

Неделя рекламы

Неделя рекламы  Энциклопедия обмана

Энциклопедия обмана