Robots.txt: что такое, зачем нужен и как его правильно заполнить

Что такое robots.txt

Файл robots.txt — это текстовый документ, который содержит инструкции по видимости сайта для поисковых ботов. Он указывает поисковикам, какие страницы ресурса нужно просканировать, а какие — исключить из этого процесса.

Это помогает распределить активность поисковых роботов: вы запрещаете им тратить время на закрытую или неактуальную информацию, чтобы вместо этого роботы сосредоточились на ключевых страницах, важных для вашего SEO.

Команды внутри robots.txt влияют именно на сканирование (краулинг), от которого, в свою очередь, зависят результаты индексации — добавления информации о вашем сайте в базу данных поисковика. Поэтому работа с этим механизмом требует большой осторожности и понимания дела.

Корректно заполненный файл — залог хорошей видимости сайта, но некоторые ошибки могут «убить» индексацию или навредить конфиденциальности информации на ваших страницах.

Зачем нужен robots.txt

Каждый поисковик составляет свой собственный индекс — огромную базу того, какие страницы существуют в интернете. Для этого они используют поисковых роботов, которые переходят по ссылкам и собирают информацию о том, что находят. Из этих данных формируется то, что мы видим в результатах поиска в Яндексе или Google.

Сканирование сайта требует времени и ресурсов, к тому же этот процесс может быть довольно хаотичным. Без инструкций роботы сами выбирают, в каком порядке посещать страницы, из-за чего сначала может быть обработана статья четырехлетней давности, а свежие новости и актуальные контакты — значительно позже.

Поэтому при заходе на сайт роботы ждут особых инструкций — как раз они и содержатся в robots.txt. С помощью этого файла можно повлиять на ход сканирования и направить алгоритмы по нужному вам пути. Обычно это делается с помощью запрета на посещение определенных страниц или разделов — тогда ресурсы поисковиков будут направлены на изучение того, что не заблокировано.

При помощи robots.txt можно:

— Заблокировать сканирование определенных ссылок. Можно помешать роботам видеть HTML-страницы, медиафайлы и файлы ресурсов (например, стили и скрипты).

— Переместить внимание поисковиков на важные страницы. Закрытые страницы не будут отвлекать роботов от информации, которая должна попасть в поиск.

— Разрешить сканирование сайта только определенным роботам. Это позволяет снизить нагрузку на сервер и контролировать трафик.

— Указать расположение sitemap.xml. Карта сайта подскажет роботам актуальный состав страниц и поможет оптимизировать их работу.

Ограничения robots.txt

Содержание robots.txt часто называют рекомендациями для поисковых роботов. Важно понимать, что этот механизм не дает вам полный контроль над поисковой выдачей:

1. robots.txt не гарантирует стопроцентной блокировки индексации. Этот метод запрещает прямое сканирование, но роботы могут попасть на ту же страницу, если на нее ссылаются другие источники. В таком случае ссылка все же может оказаться в поиске, хотя и без полноценного описания в сниппете и, скорее всего, далеко от верхних позиций. В первую очередь это нужно учитывать, когда вы работаете с персональными данными и другой чувствительной информацией.

2. Не все поисковые роботы проверяют robots.txt перед заходом на сайт. Это значит, что инструкции в файле не повлияют на сканирование со стороны некоторых краулеров от Google и Яндекс и ряда других поисковиков.

Чтобы избежать потенциальных проблем, стоит использовать более широкий комплекс технических средств. Ниже мы разберем, для каких задач robots.txt будет достаточно, а для каких потребуются дополнительные этапы.

Подписывайтесь на наш ВК и Телеграм, чтобы узнавать последние новости SEO и нейросетей, а еще подсматривать новые фишки продвижения.

Файл robots.txt — название и расположение

Для начала разберемся с тем, как подготовить сам файл. Для работы подойдет стандартное приложение Блокнот — просто создайте новый текстовый документ и задайте ему имя. Он должен называться robots.txt и никак иначе. Алгоритм чувствителен к регистру, поэтому в названии не должно быть больших букв и посторонних символов.

Разместить robots.txt нужно в корневом каталоге сайта, например: https://site.com/robots.txt. Приходя на сайт, поисковые роботы проверяют эту директорию и ожидают увидеть здесь файл с корректным названием, передающий HTTP-ответ с кодом 200 OK. Если этого не происходит, сканирование происходит в произвольном режиме, даже если правильные инструкции лежат где-то в другом месте.

Действие robots.txt распространяется на тот домен, на котором он расположен. Правила из файла по адресу https://site.com/robots.txt будут действовать на site.com, но не на m.site.com — для поддомена потребуется свой собственный документ.

Размер самого файла не должен превышать 500 КБ, иначе Яндекс его не увидит. А вот Google способен работать и с более тяжелыми файлами, но перестанет воспринимать любые команды, которые выходят за рамки указанного объема.

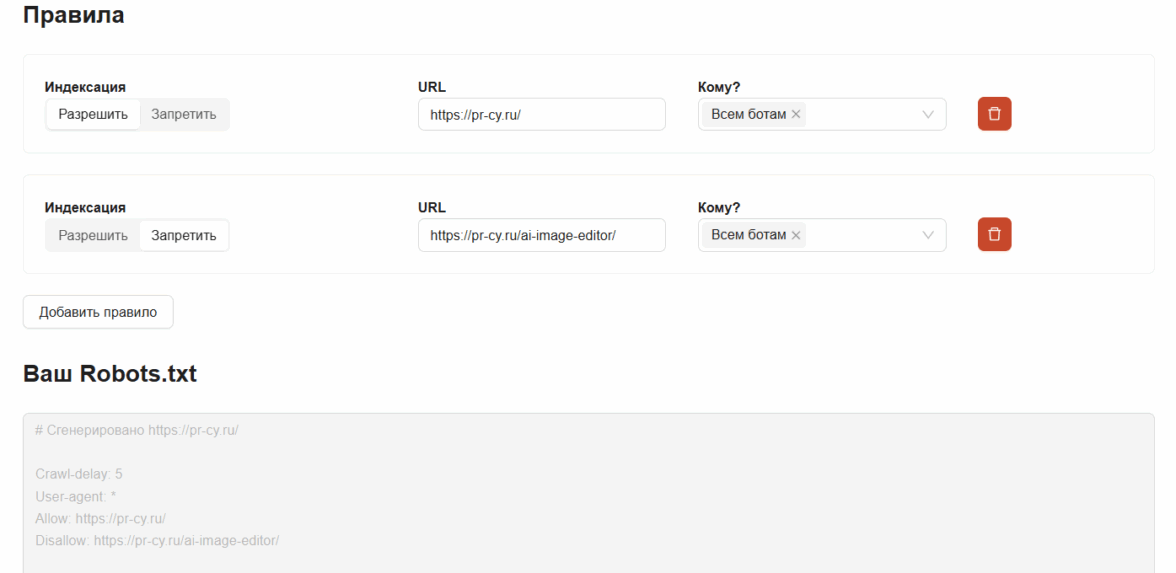

Не всегда robots.txt нужно создавать самостоятельно. Многие конструкторы сайтов формируют его автоматически, а от вас требуется только наполнить его содержимым. Еще чтобы написать robots.txt, можно воспользоваться онлайн-инструментом: генератор создаст файл за пару минут.

Интерфейс инструмента для генерации robots.txt

Как заполнить robots.txt

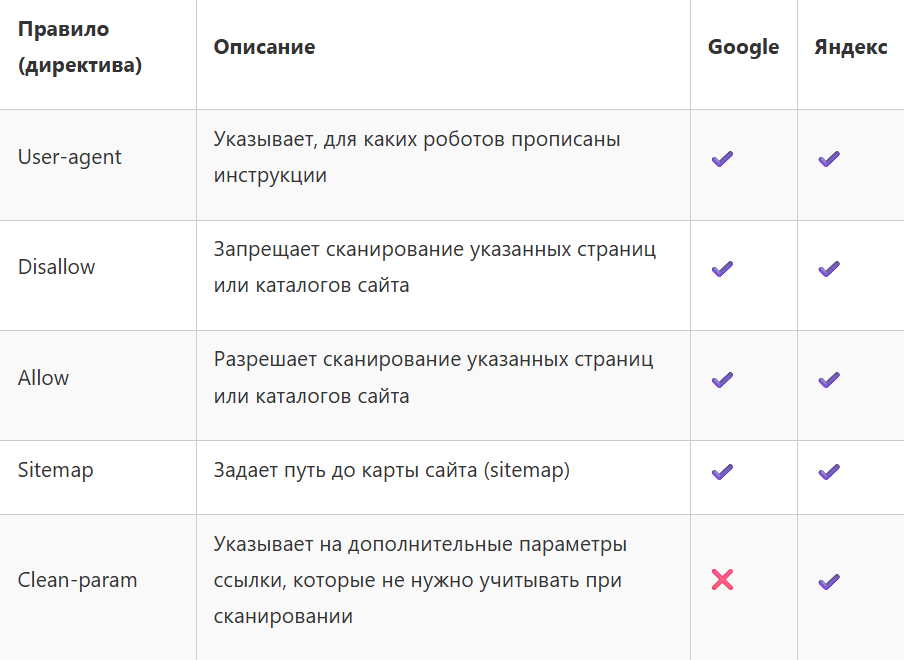

Внутри самого файла располагаются правила (так их называет Google) или директивы (такое слово использует Яндекс), которые считывают поисковые роботы. С их помощью можно установить разрешение или запрет на сканирование страниц для всех или отдельных роботов, а также указать некоторые другие параметры. Обратите внимание — Яндекс поддерживает на одну директиву больше, чем Google.

User‑agent

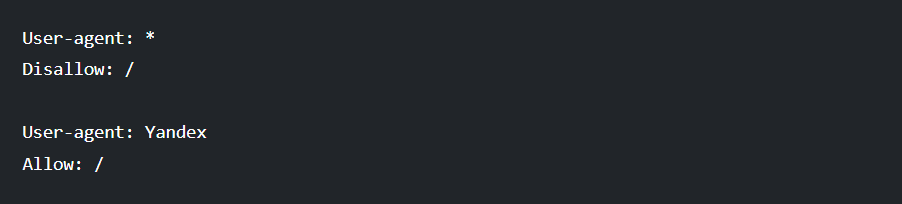

Это правило указывает, для каких поисковых роботов действуют правила, следующие далее. С помощью значения * можно указать параметры для всех основных поисковых роботов, которые занимаются сканированием для индексации.

Важно: в этот список входят не все существующие боты, а некоторые краулеры и вовсе игнорируют robots.txt. Посмотреть списки специальных роботов-исключений можно в справках Google и Яндекс.

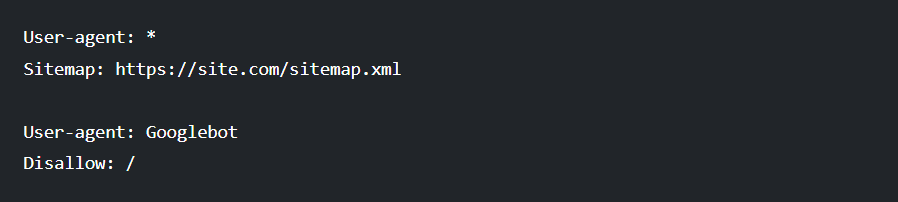

Вот пример того, как запретить сканирование сайта всем основным роботам, кроме Яндекса:

Disallow

Disallow запрещает роботам сканировать страницы по указанному адресу или целый каталог. Чтобы робот правильно обработал ссылки, они должны быть указаны в корректном виде:

— Страница — /page.html;

— Каталог — /folder/;

— Сайт целиком — /.

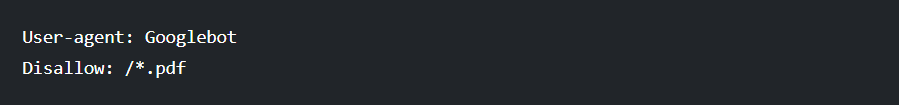

С помощью символа * можно указать все ссылки, содержащие определенные слова или форматы файлов. Например, так мы заблокируем для Google сканирование всех pdf на нашем сервере:

А так мы исключим из сканирования в Яндексе все, что содержит слово category:

Allow

Выполняет обратную Disallow функцию — разрешает сканирование страницы. Нет смысла добавлять сюда все, что вы хотите показать роботам, ведь в таком случае robots.txt станет слишком большим по объему. К тому же краулеры и так сканируют все, что не запрещено. Основная роль Allow — в том, чтобы создавать исключения из уже указанных правил.

Важно: для Allow действуют те же правила форматирования и написания ссылок, что и для Disallow.

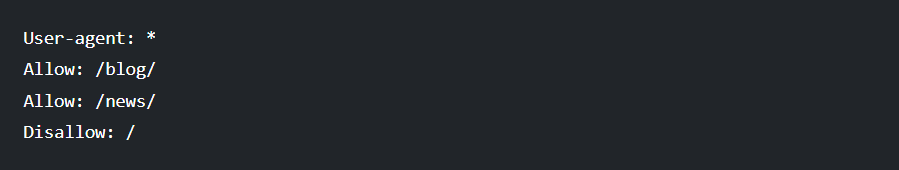

Так, например, можно запретить Google сканировать весь сайт, кроме блога:

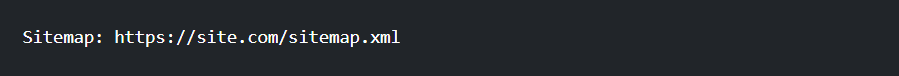

Sitemap

С помощью этой строки можно указать путь до карты сайта в файле sitemap.xml. Ссылку на него надо указать целиком, например:

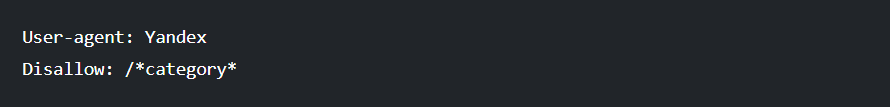

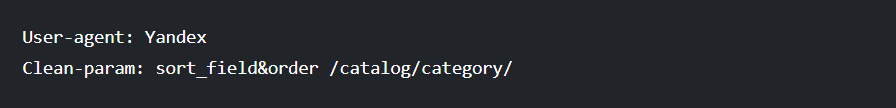

Clean-param

Роботов Яндекса можно заставить игнорировать дополнительные параметры ссылок, чтобы не тратить ресурсы сервера на дублирующийся контент и исключить его из поиска.

Например, у нас есть каталог с разными параметрами сортировки:

— site.com/catalog/category/?sort_field=price&order=asc (сортировка по цене)

— site.com/catalog/category/?sort_field=price&order=desc (сортировка по цене в обратном порядке)

— site.com/catalog/category/?sort_field=name&order=asc (сортировка по названию)

Чтобы избавиться от этих параметров и привести сканируемый URL к единому виду, нужно передать Яндексу инструкцию, в которой будут указаны лишние элементы:

А чтобы директива работала для всего сайта, не указывайте адрес ссылки — просто пропишите требуемые параметры.

Важно: Это правило не работает в Google. На замену ему предлагают использовать Disallow: /*?*. Но у такого метода есть свои риски — не просканированные ссылки с параметрами теряют вес, если их использует сторонний источник. Чтобы все работало правильно и ссылочная масса накапливалась корректно, рекомендуется добавить каждому дублю метатег rel=”canonical”.

Важные правила при работе с robots.txt

Существует пара моментов, от которых зависит, смогут ли роботы правильно считать содержание robots.txt.

Используйте только латиницу

Весь текст в robots.txt должен быть прописан латиницей. При работе с кириллическими ссылками не забудьте перевести их в нужный формат — например, с помощью Punycode-конвертера.

— Неправильно: сайт.рф

— Правильно: xn--80aswg.xn--p1ai

Соблюдайте корректную структуру

Роботы читают инструкции сверху вниз и объединяют их в группы, которые указывают, что нужно сделать. Каждая группа правил должна содержать как минимум по одной строке User-agent и Disallow или Allow — без этого условия значения User-agent объединяются.

В этом примере есть серьезная ошибка:

Мы указали sitemap для всех поисковых роботов, но это не будет разрешающей или запрещающей командой. Из-за этого правила User-agent объединяются в единую группу, а это значит, что сканирование сайта окажется закрыто не только для Googlebot, но и для всех остальных поисковиков.

Одна ссылка — одно правило

Нельзя указывать разные адреса через запятую или другие символы. Каждая ссылка должна быть оформлена в собственное правило, например:

В следующей статье расскажу, как надежно закрыть страницу от индексирования поисковыми роботами. Подпишитесь, чтобы не пропустить!

Лучшее в блогах

Вам понравится

Поисковики превращаются в нейрочаты, а старое SEO больше не спасает продажи. Если ваш бренд не существует в «голове» ИИ как понятный и проверенный источник правды, он просто перестает приводить вам клиентов. Разбираем, как с помощью GEO-оптимизации попасть в ответы нейросетей и забрать самый горячий трафик рынка

Команда Verdi обратилась к нам за редизайном и разработкой интернет-магазина. Основной особенностью стало создание уникального дизайн-кода для digital-пространства, который бы ассоциировался исключительно с брендом и выделял его среди конкурентов.

Разработчик цифровых сервисов Morizo (входит в E-Promo Group) получил «золото» Tagline Awards в категории «Лучшее приложение для умных часов». Компания впервые участвовала в этой номинации и представляла проект для сервиса электронных и аудиокниг «Литрес». Церемония награждения состоялась 5 декабря в Москве.

Неделя рекламы

Неделя рекламы  Энциклопедия обмана

Энциклопедия обмана